私たちがSDN、NFV、または他の仮想ネットワーク技術について話しているかどうかにかかわらず、1つのことを明確にする必要があります。ネットワークパケットは、物理ネットワーク上で実行されます。帯域幅、MTU、遅延などの物理ネットワークの特性は、最終的に、直接または間接的に仮想ネットワークの特性を決定します。物理ネットワークが仮想ネットワークの「天井」を決定すると言えます。

MirantisによるOpenStack Neutronの性能テストレポートでは、高速ネットワークカードの使用やMTU9000の構成など、ネットワーク機器のアップグレードと調整が伝送効率を大幅に向上させることがわかりました仮想ネットワークの ネットワークのパフォーマンスを最適化する場合、デバイスや回線をアップグレードすることによっていくつかの物理ネットワーク機能を改善できますが、ネットワークアーキテクチャに関連するものもあります。ネットワークアーキテクチャのアップグレードや変更のリスクとコストは膨大なので、データセンターの初期選択、ネットワークアーキテクチャの選択、設計は特に慎重である必要があります。一方、仮想ネットワークを設計する際には、実際の物理ネットワークアーキテクチャを考慮する必要があります。

次に、データセンターのネットワークアーキテクチャについての自分の理解について話します。

従来のデータセンターネットワークアーキテクチャ

伝統的な大規模データセンターでは、ネットワークは通常3層構造です。シスコはそれを階層的なネットワーク間モデルと呼んでいます。このモデルには、次の3つのレイヤーが含まれます。

- アクセスレイヤー:時々エッジレイヤーと呼ばれます。アクセススイッチは通常、ラックの上部に配置されているため、サーバーに物理的に接続されているToR(Top of Rack)スイッチとも呼ばれます。

- 集約レイヤー:配布レイヤーと呼ばれることもあります。アグリゲーションスイッチはアクセススイッチに接続し、ファイアウォール、SSLオフロード、侵入検知、ネットワーク分析などの他のサービスを提供します。

- コアレイヤー:コアスイッチは、データセンターに出入りするパケットの高速フォワーディングを提供し、複数のアグリゲーションレイヤーへの接続を提供します。コアスイッチは、ネットワーク全体に柔軟なL3ルーティングネットワークを提供します。

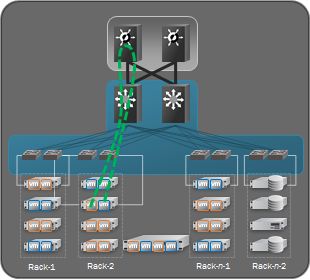

3層ネットワークのアーキテクチャ図は次のとおりです。

一般に、アグリゲーションスイッチは、L2ネットワークとL3ネットワークの間の境界点です。アグリゲーションスイッチはL2ネットワークの下にあります。上記はL3ネットワークです。集約スイッチの各グループはPOD(Point of Delivery)を管理し、各PODは独立したVLANネットワークです。1つのPODが1つのL2ブロードキャストドメインに対応するため、サーバはPOD内で移行するためにIPアドレスとデフォルトゲートウェイを変更する必要はありません。

STP(スパニングツリープロトコル)は、通常、アグリゲーションスイッチとアクセススイッチの間で使用されます。 STPでは、1つのVLANネットワークに対して1つのアグリゲーションレイヤスイッチしか使用できません。 障害発生時には他のアグリゲーションレイヤスイッチが使用されます(上図の破線)。つまり、アグリゲーション層はアクティブ/パッシブHAモードです。このように、アグリゲーションレイヤでは、複数のアグリゲーションスイッチが追加されても、1つだけがまだ動作しているため、水平展開は不可能です。CiscoのvPC(Virtual Port Channel)などの一部のプロプライエタリプロトコルでは、アグリゲーションレイヤスイッチの利用率を向上させることができますが、一方では独自のプロトコルですが、vPCでは完全な水平展開を実現できません。下の図は、L2 / L3境界線としてのコンバージェンス層を示し、vPCネットワークアーキテクチャを使用しています。

クラウドコンピューティングの発展に伴い、コンピューティングリソースがプールされます。コンピューティングリソースを任意に割り当てるために、大きな2層ネットワークアーキテクチャが必要である。つまり、データセンターネットワーク全体がL2ブロードキャストドメインであるため、IPアドレスまたはデフォルトゲートウェイを変更することなく、サーバーをどこにでも作成して移行できます。第2層のネットワークアーキテクチャ、L2 / L3境界はコアスイッチ、コアスイッチ、つまりデータセンター全体がL2ネットワークです(もちろん、複数のVLANを含むことができ、VLANは通信のためのコアスイッチ)。2番目と2番目の層のネットワークアーキテクチャを以下に示します。

大規模な2層ネットワークアーキテクチャでは、仮想マシンネットワークを柔軟に作成することができますが、その問題は明らかです。共有L2ブロードキャストドメインによってもたらされるBUM(Broadcast、Unknown Unicast、Multicast)ストームは、ネットワークサイズの増加に伴って大幅に増加し、最終的に通常のネットワークトラフィックに影響を与えます。

従来の3層ネットワークアーキテクチャは数十年にわたって存在しており、一部のデータセンターではまだ使用されています。このアーキテクチャの元の理由は何ですか?一方では、初期のL3ルーティングデバイスはL2ブリッジデバイスよりはるかに高価です。現在でも、コアスイッチは集約アクセスレイヤデバイスよりもはるかに高価です。このアーキテクチャでは、コアスイッチセットを使用して複数のアグリゲーションレイヤPODを接続できます。たとえば、上の図では、1対のコアスイッチが複数のアグリゲーションレイヤPODに接続されています。一方、初期のデータセンターでは、ほとんどのトラフィックが南北トラフィックでした。たとえば、Webアプリケーションは、データセンター外のクライアントが使用するためにサーバーにデプロイされます。このアーキテクチャを使用すると、コアスイッチ内のデータの流入と流出を制御し、

ネットワークアーキテクチャへの技術開発の影響

データセンターはデータサービス用です。技術の発展に伴い、データの内容や形式も変化しました。

- 仮想化の普及 従来のデータセンターでは、サーバーの利用率は高くありません。特定のオーバーサブスクリプションを使用する3層ネットワークアーキテクチャは、コアスイッチと他のネットワークデバイスのパフォーマンスを効果的に共有できます。しかし、仮想化の普及により、サーバーの利用率が向上します。物理サーバーは、複数の仮想マシンを仮想化し、独自のタスクを実行して独自のネットワークパスをとることができます。したがって、サーバーの使用率が高い場合は、過小な割合の割合が必要になります。ガートナーのレポート:予測:x86サーバ仮想化、2012-2018年、2014年、2014年には、2018年にはサーバの82%が仮想サーバになる予定です。仮想化がデータセンターネットワークアーキテクチャに及ぼす影響は甚大です。

- ソフトウェアアーキテクチャの分離。従来のソフトウェアアーキテクチャは専用モードで展開されています。ソフトウェアシステムは通常、物理サーバ上で動作し、物理的に他のシステムから隔離されています。しかし、モジュール化された階層化されたソフトウェアアーキテクチャの設計が今や主流になっています。システムの複数のコンポーネントは、通常、複数の仮想マシン/コンテナに分散されます。最も一般的なのは、クライアント/アプリケーション/ DBを含む3層のWEBアプリケーションです。要求はもはや仮想マシン/物理マシンではなく、複数のサーバーによって行われます。これがネットワークに与える影響は、東西トラフィックが増加していることです。

- 新しいアプリケーションの登場。従来のデータセンターは.comアプリケーション用に設計されており、このトラフィックは主にクライアントとサーバーの間にあります。分散コンピューティングでは、大きなデータが出現しており、これらのアプリケーションはデータセンター内のサーバー間で大量のトラフィックを生成します。たとえば、Hadoopは、並列コンピューティングのためにデータセンター内の数百のサーバーにデータを配信します。Facebook上のHadoopクラスタには100ペタバイト以上のデータがあると言われています。アプリケーションによっては、データセンターの東西トラフィックが膨大であることがわかります。

- 提案されたソフトウェア定義データセンター(SDDC)。SDDCは、データセンターのコンピュータストレージネットワークをソフトウェアで定義できるソフトウェア定義のデータセンターを提案しています。ネットワークに対応して、SDNです。従来の3層ネットワークアーキテクチャはSDNを念頭に置いて設計されていませんでした。

要約すると、この 技術開発では、新しいデータセンターのオーバー・キャプチャが少なくて済みます。より高い東西トラヒック帯域幅; SDNをサポートします。

これらの要件では、より高い東西交通のサポートが特に重要です。正面から南北の流れ、東西の流れ、これらの東洞は何ですか?データセンターのトラフィックは、次の一般的なカテゴリに分類できます。

- 南北トラフィック:データセンター外のクライアントとデータセンターサーバー間のトラフィック、またはデータセンターサーバーからインターネットへのトラフィック。

- East-Westトラフィック:データセンター内のサーバー間のトラフィック。

- データセンター間のトラフィック:データセンター間の災害復旧、プライベートクラウドとパブリッククラウド間の通信など、データセンター間のトラフィック。

Cisco Global Cloud Index:予測と方法論によれば、2015年〜2020年までに、データセンターのトラフィックの77%がデータセンターの内部にあります。つまり、上記の影響に関連する東西トラフィックですネットワークアーキテクチャに関する技術開発。これは東西交通が特に重要な理由です。

従来の3層ネットワークアーキテクチャでは、東西トラフィックは何ですか?

前述したように、従来の3層ネットワークアーキテクチャは、主に南北のトラフィック用に設計された.com時代に生まれました。しかし、従来のネットワークアーキテクチャでは、東西トラフィックはサポートされていません。従来の3層ネットワークアーキテクチャの東西トラフィックの傾向を分析しましょう。

まず、東西トラフィックはL2トラフィックとL3トラフィックに分かれています。

East-West L2トラフィックの場合、送信元ホストと宛先ホストの両方が同じアクセスレイヤースイッチの下にある場合、アクセススイッチが転送を完了できるため、フルスピードにすることができます。

ラックを通過する必要がある場合でも、アグリゲーションレイヤPODに配置する必要がある場合は、アグリゲーションレイヤスイッチを通過させる必要があります。帯域幅は、アグリゲーションレイヤスイッチの転送レート、ポート帯域幅、およびアグリゲーションレイヤスイッチを同時に共有するアクセスレイヤスイッチの数によって異なります。先に述べたように、STPは一般にアグリゲーションレイヤとアクセスレイヤの間で使用され、1つのアグリゲーションレイヤスイッチのみが1つのアグリゲーションレイヤPODで動作することができます。ラック全体のL2転送を満たすには、帯域幅などのアグリゲーションレイヤスイッチのパフォーマンスが、アクセスレイヤスイッチよりも大きくなる必要があります。

L2トラフィックがアグリゲーションレイヤPOD(より大きなレイヤアーキテクチャ)に及ぶ必要がある場合は、コアスイッチを通過する必要があります。同じ問題が続くと、コアスイッチの要件が高くなります。

東西L3トラフィックは、アクセスレイヤスイッチ下にあるかどうかにかかわらず、転送を完了するためにL3機能を備えたコアスイッチに移動する必要があります。以下に示すように:

これは、有益なコアスイッチリソースを浪費するだけでなく、多層転送によってネットワークの伝送遅延を増加させるヘアピントラフィックです。同様に、過大な割合の存在により、フルスピードのL3トラフィックを保証するものでもありません。

一般に、東西トラヒック帯域幅を保証するためには、より高性能なアグリゲーションスイッチおよびコアスイッチが必要とされる。一方、慎重に設計して、東西トラフィックのサーバを同じアクセススイッチの下に置くこともできます。いずれにしても、これによりコストが増加し、ユーザビリティが低下します。

ネットワークアーキテクチャに対する市場需要の変化の影響

コストと運用およびメンテナンスの要因により、データセンターは一般に展開可能な大企業です。しかし、技術の発展に伴い、中小企業の中にはデータセンターを展開する必要もあります。違いは、中小企業のニーズは一般的に小規模で開始され、ビジネスが成長するにつれて徐々にデータセンターを拡大するという点です。データセンターのサイズは、ネットワークのサイズに大きく依存します。対応するネットワークのニーズは、低コストで小規模なネットワークアーキテクチャで開始されますが、規模を拡大することができます。

従来の3層ネットワークアーキテクチャのサイズは、スイッチのポート密度に応じて、コアレイヤーデバイスのパフォーマンスと規模に依存します。最大のデータセンターは、最大かつ最高のパフォーマンスのネットワーク機器に対応しています。この種の機器は、すべてのネットワーク機器ベンダーにとって利用可能ではなく、対応する資本コスト、運用コスト、保守コストも高くなります。従来の3層ネットワークアーキテクチャでは、企業はコストとスケーラビリティのジレンマに直面します。

結論

伝統的な3層ネットワークアーキテクチャは短期間で消滅しませんが、技術と市場の発展により、その欠点がますます明らかになりつつあります。既存のネットワークアーキテクチャに基づいて改善することが非常に必要です。新しいネットワークアーキテクチャは、水平に容易に拡張できる比較的小規模のスイッチから構成されることが好ましい。HA(アクティブ - アクティブモード)をサポートし、フルスピードをサポートします。東西トラフィックは、高性能コアスイッチを購入していなくても、スーパーキャパシティを除去し、SDNなどをサポートすることができます。